Streszczenie:

Statystyka, gdy zostaje przekształcona w instrumenty władzy, redukuje ludzkie życie do abstrakcji i podważa więzi zaufania, które podtrzymują społeczeństwo — więzi, które muszą być pielęgnowane poprzez praktykę braterstwa i realne doświadczenie równości. Dążenie państwa do widzenia wszystkiego i pełnej kontroli społeczeństwa zamienia liczby w narzędzia dominacji, chroniąc władzę przed odpowiedzialnością i jednocześnie pociągając obywateli do coraz ściślejszego rozliczania.

Gandhi dostrzegł to niebezpieczeństwo na długo przed erą big data. Dla niego polityka nie mogła opierać się na liczbach ani autorytecie, lecz na wartościach praktykowanych w życiu — prawdzie, zaufaniu i niestosowaniu przemocy. W tym tkwi antidotum na bezradność i beznadziejność: w odwadze do działania, w budowaniu zaufania i w życiu wolnością, nie można pasywnie czekać, aż zostanie ona przyznana lub wstrzymana przez państwo.

Związek między statystyką a państwem

Związek między statystyką a państwem nie jest przypadkowy, lecz wynika z naturalnej dążności rządzących do pełnej (docelowo niewolniczej) kontroli nad, nomen omen, poddanymi. Od starożytności po cyfrową teraźniejszość, władcy używali liczb nie tylko do opisu społeczeństwa, ale do jego obserwowania, zarządzania, kontrolowania i kształtowania. To długotrwałe powiązanie rodzi pilne pytanie, czy można to zmienić?

Ostatnie dwa tysiąclecia pokazują trwałość więzów łączących państwo ze statystyką.

Najwcześniejsze korzenie pojęcia statystyki jako dyscypliny naukowej, która pozwala nam zrozumieć złożoność świata poprzez zbieranie dużej ilości informacji mającej na celu wykrycie prawidłowości i jeśli się da to zapisanie tych prawidłowości w postaci wzorów matematycznych w celu budowania modeli, zarówno poznawczych jak i, głównie, przewidywawczych można wyśledzić już u Pitagorasa w starożytnej Grecji.

Władcy starożytnego Rzymu odkryli, że technika zbierania i przetwarzania liczb jest użytecznym sposobem na ocenę i wykorzystanie zasobów, które mogli zmobilizować, zarówno ludzkich, jak i materialnych. Uzyskanie poczucia status — stanu rzeczy — miało, w nadziei rzymskich władców, umożliwić im znacznie lepsze zarządzanie sprawami państwa.

Wieki później, z łacińskiego słowa statusużywanego w starożytnym Rzymie, a oznaczającego stan lub położenie, wyłoniło się włoskie słowo statista — mąż stanu. Do połowy XVIII wieku Niemcy przyjęli statistik, jako „arytmetykę polityczną” – „naukę o państwie” lub „naukę o rządzeniu”.

Angielskie słowo statistics było w użyciu pod koniec XVIII wieku, a jego znaczenie rozszerzyło się wraz z pierwszymi sprawozdaniami statystycznymi tworzonymi w Szkocji w latach 90. XVIII wieku przez John’aSinclair’a (1754–1835).

W ciągu następnego stulecia statystyka nabrała dzisiejszego znaczenia zbierania i analizowania danych na dowolny temat.

Jednak przez cały XX wiek, w miarę pojawiania się nowoczesnych państw narodowych i wraz z upadkiem porządku imperialno-kolonialnego, władcy nie tylko dostrzegli użyteczność statystyki dla spraw państwa, ale także zdali sobie sprawę, że te same statystyki mogą być wykorzystywane przez ludzi do pociągania do odpowiedzialności tych u władzy politycznej. Jak pokazał francuski statystyk, socjolog i historyk nauki Alain Desrosières (1940–2013) w swoim dziele „The Politics of Large Numbers” (1998), nowoczesne państwo i nowoczesna statystyka dojrzewały razem, wzajemnie się kształtując i legitymizując.

Państwa autorytarne i komunistyczne były jednymi z pierwszych, które znalazły sposoby na zarządzanie i manipulowanie swoimi statystykami, aby uniknąć odpowiedzialności politycznej. Dziś to wygoda polityczna rutynowo decyduje o zakresie i jakości statystyk podawanych do wiadomości publicznej przez państwo. Epidemia COVID dała jasny wgląd w wyłaniającą się nową normalność w politycznym wykorzystaniu i nadużywaniu statystyki. Obecnie trudno znaleźć państwo, niezależnie od ideologii, które byłoby odporne na zamawianie danych pasujących do priorytetów politycznych lub pomijanie danych niewygodnych politycznie.

Badania AndreBriviba, Bruno S. Frey i in. opublikowane w latach (2022/2024) w artykule „Governments manipulate official Statistics: Institutions matter” (Rządy manipulują oficjalnymi statystykami: instytucje mają znaczenie) wzmacniają ten szerszy wzorzec: manipulacja lub tłumienie niewygodnych statystyk nie ma charakteru ideologicznego, lecz strukturalny. Statystyki kształtowane są przez wskazania tych, którzy są u władzy,a ich wynik musi być korzystny politycznie. Do kształtowania statystyk rządzący stosują instytucjonalne zabezpieczenia lub ich brak. A wyższa wiarygodność statystyk zależy od stopnia niezależności instytucji państwowych od rządzących oraz odpowiednich praw zapewniających tę niezależność.

Ostatnie kontrowersje w krajach tak różnych jak Indie i Stany Zjednoczone dodatkowo podkreślają ten punkt: nawet tam, gdzie istnieją niezależne instytucje statystyczne, ich autonomia okazuje się krucha w obliczu priorytetów politycznych aktualnie sprawującego rządu. Bo zawsze to rządy decydują o zarobkach w instytucjach zwanych państwowymi.

Pytanie brzmi zatem: czy można zaprojektować instytucje, aby zapewnić niezależność i integralność statystyki, oraz innych dziedzin nauki, od bieżącej polityki? A może trzeba na nowo przemyśleć politykę, aby pociągać aktualnie sprawujący rząd do odpowiedzialności za wartości i praktyki polityczne, które wykraczają poza statystykę?

Matematyka, Aproksymacja i Miraż Pewności

Matematyka od dawna jest celebrowana jako ten jeden prawdziwie uniwersalny język, podziwiany za rygor swojej logiki i elegancję swoich form. Jej „nieuzasadniona skuteczność w opisywaniu świata naturalnego”, jak ujął tow 1960 rokuwęgiersko-amerykański fizyk teoretyczny i matematykEugeneWigner(1902–1995), olśniła pokolenia. Siła przewidywania nauki, zbudowana na formułach matematycznych, oraz praktyczne cuda nowych technologii, tylko pogłębiły ten zachwyt. Jednak sam ten blask często nie pozwala nam dostrzec jej wewnętrznej natury: żaden wynik matematyczny nie jest bowiem idealnie dokładny. Zawsze jest to tylko przybliżenie, które zależy od przyjętych założeń (teorii) i jakości zebranych informacji (danych).

Rachunkowość i statystyka były jednymi z najwcześniejszych prób zastosowania matematyki do spraw ludzkich. Matematyka była postrzegana jako coś, co wnosi tę samą pewność do życia społecznego i ekonomicznego, jaką wniosła do nauk fizycznych. Ale zakres dokładności matematyki w naukach społecznych był i jest nadal podważany.

Tym niemniej nauki techniczne również zetknęły się z zagadnieniem precyzji swych modeli przewidywawczych. Odpowiedzią naukowców zajmujących się tak zwanymi naukami stosowanymi, które koncentrują się na tym, jak wiedzę teoretyczną wykorzystać w życiu codziennym, przemyśle, medycynie czy technologii były: teoria systemów (twórca: austriacki biolog i filozof Ludwig von Bertalanffy, 1901–1972), cybernetyka (twórca: angielski psychiatra Ross Ashby, 1903-1972), teoria stabilności (twórca: rosyjski matematyk i mechanik Aleksandr Lapunow 1857-1918) i teoria gier (twórca: węgiersko-amerykański matematyk John von Neumann, 1903–1957).

W oparciu o te dziedziny w roku 2009 przez Jana Kubania została zaproponowana nowa dziedzina naukowa Fizyka Życia. Jej celem jest badanie wszystkich procesów życiowych od poziomu cząstek chemicznych do obiektów żywych piątego poziomu organizacyjnego i ich wzajemnych relacji. Nie daje ona precyzyjnych odpowiedzi, nie mniej jednak pozwala na odkrywanie prawidłowości, określanie trendów i dążności systemów żywych i ich zbiorów, wyznaczanie przestrzeni możliwych zdarzeń i obliczanie gęstości prawdopodobieństwa zaistnienia takich, a nie innych zjawisk.

Tak więc bardziej lub mniej dokładna analiza zjawisk technicznych i społecznych jest już zasadniczo możliwa. Lecz o ile w naukach technicznych mamy do czynienia z pełnym wykorzystaniem takich analiz o tyle w naukach społecznych są w praktyce nieobecne. Jedno i drugie wynika z… woli rządzących. Nauki techniczne i ich rozwój są im potrzebne, ot choćby do prowadzenia wojen, natomiast nauki społeczne, które ujawniłyby ich niekompetencje absolutnie nie. Stąd fałszowanie statystyk i brak przyzwolenia na rzetelne, znane w naukach technicznych, analizowanie procesów społecznych.

W dwudziestym wieku „Socjalistyczna debata kalkulacyjna”, w której jako krytycy występowaliLudwig von Mises i Friedrich Hayek, którzy udowadniali niemożliwość centralnego planowania — podkreśliła, że wiedza ekonomiczna jest rozproszona, kontekstualna i nie daje się zredukować do jednej formuły. Ich ostrzeżenie wciąż rezonuje: agregacja nie może zastąpić rozproszonych osądów i żywych doświadczeń, za pomocą których ludzie poruszają się w codziennym życiu.

Sama współczesna fizyka odzwierciedla tę przyrostową i tymczasową naturę wiedzy. Teoria grawitacji Newtona rządziła naukowym rozumieniem przez trzy stulecia, zanim Einstein przemyślał ją na nowo poprzez teorię względności. Sto lat później luka między teorią względności a fizyką kwantową nadal pozostaje nierozwiązana, mimo że obie współistnieją w praktyce.

Inżynierowie nadal polegają na klasycznej mechanice Newtona w większości zastosowań, podczas gdy naukowcy badają tajemnice teorii względności i teorii kwantowej w skali kosmicznej i subatomowej. Wiedza postępuje, ale nigdy w pełni nie zamyka przepaści między ludzkim rozumem a nieskończoną złożonością rzeczywistości.

Więcej na ten temat można przeczytać w dodatku „Fizyka w naukach społecznych”.

Podstawowe znaczenie statystyki tkwi właśnie w tym uznaniu luki między ludzką wiedzą a nieskończonym zakresem rzeczywistości. Mimo to, wciąż na nowo ulegamy urokowi pewności oferowanemu przez technologów i przez tych, którzy obsadzają instytucje państwowe. Ich autorytet często opiera się na roszczeniach do absolutnej pewności, wbrew zarówno ludzkiej naturze, jak i rzeczywistości naszego położenia.

To roszczenie do absolutnej pewności siebie wynika u polityków z następujących czynników:

- Ludzie podświadomie obdarzają zaufaniem ludzi pewnych siebie wypowiadających się w duchu absolutnej pewności i wybierają ich jako swych przedstawicieli

- Nieudolne działania polityków są maskowane przez tę pewność siebie, propagandę, dodruk pieniędzy i ograniczanie wolności słowa,

- Politycy nie ponoszą bezpośredniej odpowiedzialności za swoje działania

- Powstaje pętla dodatniego sprzężenia zwrotnego: polityk jest przekonany, że robi dobrze, a sterowana przez niego propaganda coraz bardziej wzmacnia to jego przekonanie

Dzisiejsze debaty wokół sztucznej inteligencji i jej nienasyconego zapotrzebowania na dane i moc obliczeniową są, pod wieloma względami, przedłużeniem tej stuleciami trwającej praktyki. Wiara, że coraz większa moc obliczeniowa może zasypać lukę między skończoną ludzką wiedzą a nieskończoną rzeczywistością, napędza dążenie do większej ilości danych, większej liczby modeli, większej liczby przewidywań. Ale przepaść pozostaje. Bez względu na to, jak olśniewające są wyniki, technika jest nadal ograniczona swoimi założeniami i ślepa na to, co jest niemierzalne.

Niebezpieczeństwo nie tkwi w samej matematyce, ale w iluzji, którą ona wytwarza, gdy zostaje zaprzęgnięta do służby władzy. Autorytet przewidywania liczb, gdy jest używany przez państwo lub przez tych, którzy obiecują technologiczne zbawienie, staje się narzędziem perswazji i uległości. Ta świadoma ignorancja ograniczeń — odmowa uznania tego, czego nie da się zmierzyć — pozwala pomylić technikę z prawdą, a kontrolę z wiedzą.

W erze informacji, dane są reklamowane jako nowa waluta. Informacja jest obiecywana jako moc pociągania do odpowiedzialności tych, którzy są u władzy. Ale w rzeczywistości ci u władzy zawsze używali danych i informacji, aby pociągać ludzi do coraz większej odpowiedzialności przed władzą. Ta odwieczna technika jest kontynuowana nieprzerwanie do obecnej epoki informacji, wbrew rzeczywistości, naturze nauki i kondycji ludzkiej.

W tym kontekście eksperymenty Gandhiego z prawdą na poziomie osobistym odzwierciedlają pokorę nauki na poziomie zbiorowym: postęp jest przyrostowy, omylny i wiecznie niepełny. Rzeczywistość nie może być podbita przez obliczenia. Trzeba ją przeżywać, napotkać z pokorą, a poprzez dialog budować wspólną perspektywę na prawdę.

W tym miejscu warto się zapoznać z pojęciem Bariery Przetwarzania Informacji. Bariera ta polega na tym, że w złożonych modelach rzeczywistych, w tym obiektów żywych, konieczne jest branie pod uwagę historii zachowań tych obiektów. A to jest po prostu niemożliwe. Najprostszym dowodem na to jest to, że nie da się zbudować takiego komputera, który pamiętałby historię stanów wszystkich komórek swojej pamięci.

Technika Państwa w Imię Nowoczesności

Rosnąca intensywność walki z nieokreślonością — czy to wymiany ekonomicznej, relacji osobistych, tożsamości, czy migracji — jest zakorzeniona w pragnieniu identyfikacji, kategoryzacji i obliczania. Państwo skwapliwie powołuje się na prawo, aby uświęcić teniby realne obliczenia do nieokreślonych tożsamości.

Jest to emocjonalna i epistemologiczna odmowa zaakceptowania niepewności i niewiadomych nieodłącznie związanych z nieokreślonością, które czynią ją nieprzewidywalną ze stuprocentową dokładnością.

Od Sokratesa po Gandhiego, od Adama Smitha po Hannah Arendt, od Hayeka po ElinorOstrom, wielu rozpoznało to wewnętrzne ograniczenie ludzkiej wiedzy. Dążyli oni do wiedzy nie poprzez agregowanie i homogenizowanie, ale poprzez angażowanie się w to, co dyskretne, rozproszone i lokalne. Cenili różnorodne perspektywy i ścieżki, szukając przebłysku uniwersalności poprzez nieskończone różnorodności. Cenili dążenie do prawdy przez małe „p”, jednocześnie uznając, że ostateczna Prawda przez duże„P”nie jest ani dostępna ani policzalna.

Prawdziwa iluzja polega na wierze, że Prawda tkwi w statystyce — i z tej iluzji, państwo, uzbrojone w nieograniczoną władzę, powołuje się na zalegalizowaną przemoc, aby narzucić swoją błędną wizję prawdy i rzeczywistości.

Statystyka jest, w najlepszym wypadku, techniką użyteczną w wąskim kontekście. Jednak historia pokazuje, że każda obiecująca technika jest wkrótce przejęta przez państwo i… wykorzystana jako instrument władzy.

Właśnie przed tym wykorzystaniem technologii jako środka kontroli ostrzegali Tołstoj, Tagore i Gandhi, a później Jacques Ellul. Ich krytyka nie dotyczyła samej technologii, ale ubóstwa wyobraźni politycznej, które to ubóstwo pozwoliło społeczeństwom pomylić technikę z prawdą. W imię ochrony tożsamości sekciarskiej, społeczeństwa oddały swoje wspólne człowieczeństwo samym technologiom władzy, które je zniewoliły.

Jeśli statystyka i technologia są nieustannie przystosowywane jako instrumenty kontroli, to wyzwaniem jest odkrycie na nowo polityki, która opiera się tej logice i potwierdza wartości, których nie da się sprowadzić do liczb.

Odbieranie Polityki w Erze Danych

Wyraźna lekcja płynąca z tej symbiotycznej relacji między państwem a statystyką jest jasna: co można zmierzyć, można monitorować, a co można monitorować, można kontrolować. James C. Scott, w książce „Oczami państwa”(SeeingLike a State)z roku 1998, opisuje to dążenie jako poszukiwanie „czytelności” — uczynienia społeczeństwa widocznym dla władzy, aby można nim było zarządzać. Im więcej statystyk gromadzi państwo, tym bardziej scentralizowana staje się jego władza, ale tym bardziej rząd oddala się od rządzonych.

Ta asymetria informacji umożliwia państwu pociąganie obywateli do odpowiedzialności, jednocześnie chroniąc rządzących przed kontrolą — a to niestety jest odwróceniemidei demokracji.

Nie jest zatem przypadkiem, że dane są projektowane jako nowa waluta, a informacja jako nowe narzędzie władzy, nawet gdy ogranicza się sprawczość i autonomię jednostek. Jak argumentuje Theodore Porter w książce „Wiara w liczby”(Trust in Numbers)z roku 1995, kwantyfikacja często służy biurokratycznym roszczeniom do obiektywności i legitymizacji. Statystyczne spojrzenie na poziomie makro odmawia legitymizacji nieformalnym instytucjom, za pomocą których ludzie faktycznie współpracują, wprowadzają innowacje i rozwiązują różnice na poziomie mikro.

Ta intelektualna fascynacja liczbami spycha na boczny tor także „niewidzialną rękę”, którą opisał Adam Smith — spontaniczną dążność do innowacyjnej wytwórczości, która rozkwita w wyniku niepoliczalnej liczy interakcji międzyludzkich i jest niemożliwa do osiągnięcia przez centralne sterowanie. Redukując ludzkie życie do agregatów i abstrakcji, państwo zaciera więzi zaufania, które podtrzymują społeczeństwo, więzi, które muszą być pielęgnowane poprzez praktykę braterskiej wzajemności i żywe doświadczenie równości.

Ciekawym dowodem tej redukcji ludzi do agregatów i abstrakcji jest, w zasadzie, całkowity brak, takich pojęć jak motywacja i wydajność pracy w dyskursie społecznym, mediach głównego nurtu, a nawet w ekonomicznym środowisku naukowym. W Polsce w przestrzeni publicznej mówienie o motywacji i wydajności pracy pojawiło się na krótko w końcowej fazie upadku reżimu socjalistycznego, by tuż po transformacji ustrojowej ponownie na trwałe z tej przestrzeni zniknąć.

Gandhi rozpoznał to niebezpieczeństwo na długo przed erą big data. Nalegał, aby polityka opierała się nie na liczbach, ani na władzy autorytetu, lecz na wartościach — prawdzie, zaufaniu i niestosowaniu przemocy — które są przeżywane w codziennej praktyce, a nie uchwycone w statystyce. Tam, gdzie państwo statystyczne prosperuje na dystansie i agregacji, polityka Gandhiego czerpała siłę z bliskości i odpowiedzialności. Jeśli wolność ma przetrwać, polityka musi zostać odzyskana jako praktyka wartości, a tych żadna metryka nie jest w stanie zmierzyć. Powtórzmy raz jeszcze: Antidotum na wszelkie poczucie bezradności i beznadziejności leży w odwadze do działania, budowaniu zaufania i życiu w wolności, a nie w czekaniu, aż zostaną one przyznane przez statystykę lub wstrzymane wedle woli państwa.

Dodatki:

Alain Desrosières

Alain Desrosières (1940–2013) był francuskim statystykiem, socjologiem i historykiem nauki.

Był pracownikiem Narodowego Instytutu Statystyki i Studiów Ekonomicznych (INSEE) w Paryżu.

Jego najbardziej znanym dziełem jest książka „Polityka wielkich liczb: Historia Statystycznego Rozumowania” (w oryginale francuskim: La politique des grandsnombres), opublikowana w 1993 roku (wydanie angielskie w 1998 roku).

W kontekście przytoczonego tekstu, Desrosières został wspomniany w celu zilustrowania tezy, że:

- Nowoczesne państwo i nowoczesna statystyka dojrzewały razem, wzajemnie się kształtując i legitymizując.

Jego prace koncentrowały się na analizie, w jaki sposób ewolucja nowoczesnej statystyki była nierozerwalnie związana z wiedzą i władzą rządów. Pokazywał, że statystyka nie jest neutralna, lecz jest narzędziem konstruowania faktów społecznych (takich jak bezrobocie czy klasyfikacje społeczne) i zarządzania nimi przez państwo.

Badania Briviba

Fragment o „badaniach Brivibai innychz 2022/2024” odnosi się do prac naukowych, które analizują manipulowanie oficjalnymi statystykami przez rządy i dlaczego do tego dochodzi.

Chodzi tu o artykuł ekonomistów (AndreBriviba, Bruno S. Frey i in.) pt. „GovernmentsmanipulateofficialStatistics: Institutionsmatter” (Rządy manipulują oficjalnymi statystykami: instytucje mają znaczenie).

Główny Wniosek Badania

Badanie to wzmacnia tezę, że manipulowanie statystykami przez państwo jest problemem strukturalnym, a nie tylko ideologicznym. Pokazuje, że na skłonność do manipulacji danymi (np. PKB):

- wpływają przede wszystkim czynniki instytucjonalne,

- jest to kształtowane przez bodźcewysyłane przez osoby sprawujące władzę, czyli jest to korzystne dla tych osób,

- zależy od istnienia lub braku zabezpieczeń instytucjonalnych, czyli autonomii instytucji i odpowiedniego systemu prawnego.

Kluczowe Odkrycia w Kontekście Polityki

Autorzy, badając różnice między oficjalnymi danymi o PKB a PKB szacowanym na podstawie danych satelitarnych (oświetlenie nocne 💡), wykazali, że:

- Demokracja i otwartość gospodarcza zazwyczaj zmniejszają skłonność do manipulacji danymi.

- Decentralizacja może zwiększać manipulację (ponieważ manipulacja może odbywać się na różnych poziomach władzy).

- Co ciekawe, samo istnienie niezależności urzędu statystycznego i wolności prasy nie zawsze okazało się wystarczające do powstrzymania manipulacji.

Ten wniosek (że autonomia instytucji jest krucha wobec priorytetów politycznych) idealnie wspiera ogólną tezę tekstuBaruna Mitry: liczby są przekształcane w narzędzia dominacji, które chronią władzę przed odpowiedzialnością.

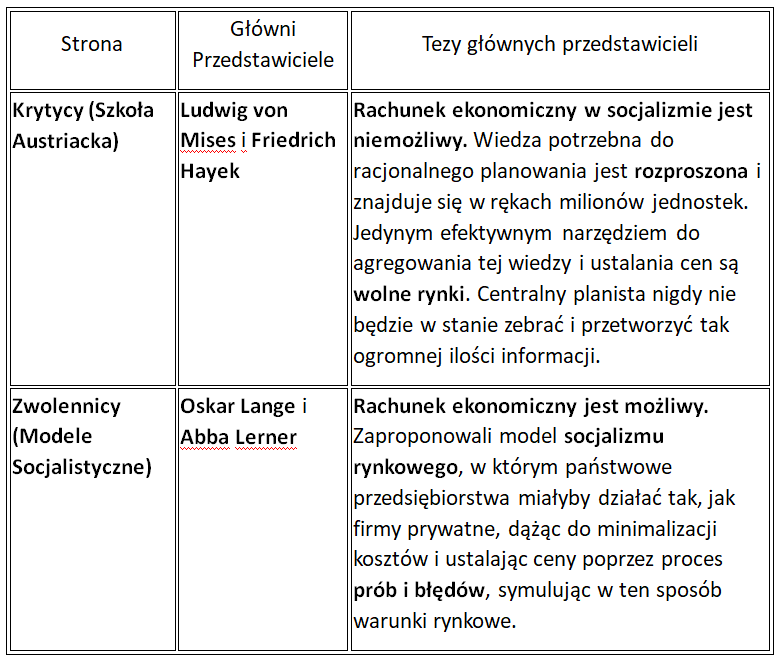

Socjalistyczna debata kalkulacyjna

Socjalistyczna debata kalkulacyjna (ang. Socialist Calculation Debate) to seria dyskusji ekonomicznych, które miały miejsce głównie w pierwszej połowie XX wieku. Dotyczyły one fundamentalnego pytania: czy gospodarka socjalistyczna, w której środki produkcji są własnością państwową, jest w stanie racjonalnie i efektywnie alokować zasoby i ustalać ceny, zastępując mechanizm rynkowy?

Główne Strony Debaty

Dyskusja ta skupiała się na problemie podejmowania racjonalnych decyzji gospodarczych bez cen rynkowych, które w kapitalizmie wynikają ze swobodnej interakcji popytu i podaży.

Znaczenie i Wynik

Krytyka ze strony Misesa i Hayeka, szczególnie ta dotycząca rozproszonej natury wiedzy, zyskała historyczne potwierdzenie po upadku gospodarek centralnie planowanych (np. Związku Radzieckiego) pod koniec XX wieku.

- Centralny Planista vs. Wiedza: Debata pokazała, że największym problemem centralnego planowania nie jest samo obliczenie skomplikowanych równań (jak to postrzegano na początku), lecz niemożność zdobycia, przetworzenia i efektywnego wykorzystania lokalnej, kontekstualnej wiedzy (np. o konkretnych preferencjach klientów czy innowacjach technologicznych), która jest zakodowana w cenach rynkowych.

- Wpływ na Współczesność: Współcześnie ostrzeżenia Hayeka, że agregacja nie może zastąpić rozproszonych osądów i żywych doświadczeń, są często przywoływane w kontekście big data i sztucznej inteligencji, co widzieliśmy we fragmencie tekstuBaruna Mitry. Pytanie brzmi: czy nawet najpotężniejszy algorytm może kiedykolwiek zastąpić kreatywność i sygnały cenowe wolnego rynku?

Odpowiedź brzmi, ze względu na barierę przetwarzania informacji nie zastąpi nigdy. Natomiast wniosek z tej dyskusji, który powinien być traktowany jako prawo Fizyki Życia, jest taki, że jedynie gospodarka wolnorynkowa jest gospodarką wytwórczą, innowacyjną, doskonalącą, sensowną, czyli rozwijającą społeczeństwo.

Fizyka w naukach społecznych

Wstęp do książki Norbert’aWiener’a „Cybernetyka, a społeczeństwo”, który omawia zagadnienie dokładności wyników w analizie procesów technicznych i społecznych:

[…]

Fizyka Newtona, panująca prawie niepodzielnie od końca siedemnastego do końca dziewiętnastego wieku, opisywała świat, w którym wszystko dzieje się według ustalonego prawa, świat zwarty i dokładnie zorganizowany, w którym cała przyszłość wynika ściśle z całej przeszłości. Takiego obrazu nie można nigdy ani w pełni potwierdzić, ani na podstawie doświadczalnej w pełni odrzucić. W znacznej mierze jest to pojęcie świata, które uzupełnia doświadczenie, ale zarazem jest w pewien sposób bardziej uniwersalne od tego wszystkiego, co da się eksperymentalnie potwierdzić. Przy pomocy naszych niedoskonałych doświadczeń nie możemy nigdy sprawdzić, czy taki lub inny zbiór praw fizycznych potwierdza się całkowicie. Lecz newtonowska koncepcja musiała formułować zjawiska fizyczne tak, jak gdyby podlegały one takim prawom. Pogląd ten przestał już panować w fizyce, a ludźmi, którzy najwięcej przyczynili się do jego upadku, byli Boltzmann w Niemczech i Gibbs w Stanach Zjednoczonych.

Ci dwaj fizycy w sposób radykalny zastosowali nową, pobudzającą koncepcję. Wykorzystanie statystyki w fizyce nie było może czymś zupełnie nowym, ponieważ już Maxwell i inni rozważali światy złożone z wielkiej liczby cząsteczek, które z konieczności trzeba było traktować w sposób statystyczny. Ale dziełem Boltzmanna i Gibbsa było zastosowanie statystyki w fizyce w sposób dużo głębszy, tak że podejście statystyczne zaczęło obowiązywać nie tylko w układach niezmiernie złożonych, lecz nawet w układach tak prostych, jak pojedyncza cząsteczka w polu siły.

Statystyka jest nauką o rozkładzie, a rozkład brany pod uwagę przez tych współczesnych fizyków nie dotyczył wielkich liczb podobnych cząsteczek, lecz różnych położeń i prędkości, jako początkowych wartości układu fizycznego. Innymi słowy, w systemie Newtona te same prawa fizyczne mają zastosowanie do wielu układów o różnych położeniach początkowych i różnych pędach. Obecnie statystycy rzucili na ten problem nowe światło. Zachowali zasadę odróżniania układów na podstawie ich całkowitej energii, lecz odrzucili założenie, na mocy którego układy o tej samej całkowitej energii można zawsze odróżnić w sposób jednoznaczny i opisywać za pomocą ustalonych praw aż do ostatecznego wyczerpania przyczyn.

W pracy Newtona tkwiło pewne ważne milczące zastrzeżenie, które osiemnaste stulecie, zapatrzone w Newtona, zignorowało. Żadne pomiary fizyczne nie są nigdy ścisłe. To, co możemy powiedzieć o jakiejś maszynie lub innym układzie dynamicznym, w rzeczywistości odnosi się nie do tego, czego mamy oczekiwać, gdy początkowe położenia i pędy zostaną nam dane z absolutną dokładnością, ponieważ to się nigdy nie zdarza. Odnosi się natomiast do tego, czego mamy oczekiwać, gdy zostaną nam dane z taką dokładnością, jaką można uzyskać. Oznacza to po prostu, że nie znamy wprawdzie ściśle warunków początkowych, ale wiemy coś o ich rozkładzie. Innymi słowy, funkcjonalny aspekt fizyki musi uwzględniać niepewność i możliwość przypadkowości. Zasługą Gibbsa było ukazanie po raz pierwszy jasnej metody naukowej, która brała tę możliwość pod uwagę.

Historyk nauki na próżno szuka jednej linii rozwoju. Praca Gibbsa, dobrze skrojona, była źle uszyta, toteż innym przypadło w udziale dokończenie tego, co rozpoczął. Oparł on swą pracę na następującym intuicyjnym założeniu. Układ fizyczny należy do pewnej klasy układów scharakteryzowanych rozkładem statystycznym. Układ ten we wszystkich niemal przypadkach odtwarza rozkład istniejący w danym momencie w obrębie całej klasy układów. Innymi słowy, jeśli dany układ istnieje dostatecznie długo, to w pewnych okolicznościach przechodzi przez wszystkie rozkłady położenia i pędu, które są możliwe przy posiadanej przezeń energii.

Ostatnie zdanie jest jednak prawdziwe i możliwe tylko w odniesieniu do układów bardzo prostych. Mimo wszystko, inna droga prowadzi do wyników, których Gibbs potrzebował na poparcie swej hipotezy. Ironią dziejów jest, że drogę tę badano bardzo dokładnie w Paryżu w tym samym czasie, kiedy Gibbs pracował w New Haven. Dopiero w r. 1920 praca wykonana w Paryżu spotkała się z pracą wykonaną w New Haven i wydała owoce. Miałem, jak sądzę, zaszczyt pomagania przy porodzie pierwszego dziecka z tego związku.

Gibbs musiał pracować posługując się teoriami pomiaru i prawdopodobieństwa, które już wtedy liczyły sobie co najmniej dwadzieścia pięć lat i były rażąco niewystarczające dla jego potrzeb. W tym samym jednak czasie w Paryżu Borel i Lebesgue opracowywali teorię całkowania, która miała się okazać przydatna do celów Gibbsa. Borel był matematykiem, który już zapewnił był sobie reputację w dziedzinie teorii prawdopodobieństwa i znakomicie wyczuwał problemy fizyki. Wiele zdziałał w teorii pomiaru, lecz nie doszedł do punktu, w którym mógłby swoją pracę zamknąć w formie doprowadzonej do końca teorii. Dokonał tego jego uczeń Lebesgue, który był człowiekiem zupełnie innego pokroju. Nie miał zrozumienia dla fizyki i nie interesował się nią. Rozwiązał jednak problem sformułowany przez Borela, chociaż rozwiązanie to traktował jedynie jako narzędzie w pracy nad szeregiem Fouriera i innymi działami czystej matematyki. Doszło między nimi do sporu, gdy zaczęli się ubiegać o przyjęcie do Francuskiej Akademii Nauk. Wreszcie po uprzednim wzajemnym oczernieniu się obaj dostąpili tego zaszczytu. Borel nie przestawał podkreślać wagi pracy Lebesgue’a i swojej własnej jako narzędzia w badaniach fizycznych. Sądzę jednak, że ja sam, w r. 1920, byłem pierwszym, który zastosował całkę Lebesgue’a do problemu specyficznie fizycznego, a mianowicie do ruchów Browna.

Nastąpiło to w wiele lat po śmierci Gibbsa, i jego praca przez dwadzieścia lat pozostała jedną z tych tajemnic nauki, które wbrew oczekiwaniom wydają owoce, chociaż wydawałoby się, że nie powinny dawać żadnych. Wiele ludzi intuicją wyprzedza własną epokę: dotyczy to również fizyki teoretycznej. Gibbs pojęcie prawdopodobieństwa wprowadził do fizyki, zanim jeszcze powstała właściwa teoria prawdopodobieństwa, której potrzebował. Ale mimo wszystko, jestem przekonany, że to Gibbsowi raczej niż Einsteinowi, Heisenbergowi czy Planckowi musimy przypisać dokonanie pierwszego wielkiego przewrotu w fizyce dwudziestego wieku.

Na skutek tego przełomu fizyka przestała rościć sobie pretensje do zajmowania się tym, co się na pewno zdarzy, a zajmuje się tym, co się zdarzy z ogromnym prawdopodobieństwem. Na początku, w pracy Gibbsa, ta postawa nakładała się na substrat newtonowski, gdzie elementami, których prawdopodobieństwo stanowiło przedmiot badania, były układy stosujące się do wszystkich praw fizyki Newtona. Teoria Gibbsa była w zasadzie nowa, lecz permutacje, z jakimi dawała się pogodzić, były takie same jak te, które rozpatrywał Newton. Od tego czasu sztywny substrat newtonowski w fizyce został odrzucony lub zmodyfikowany, i gibbsowska zasada możliwości tkwi obecnie u podstaw fizyki bez żadnych ornamentów. Zapewne, ostatnie słowo w tej sprawie nie zostało jeszcze powiedziane. Einstein, w pewnych okresach i De Broglie nie przestawali twierdzić, że sztywny deterministyczny świat jest bardziej do przyjęcia niż świat oparty o zasadę prawdopodobieństwa. Lecz ci wielcy uczeni tylko osłaniają odwrót przed przeważającymi siłami młodego pokolenia.

Jedna z ciekawych zmian polega na tym, że w koncepcji probabilistycznej przestaliśmy się zajmować wielkościami i twierdzeniami dotyczącymi jakiegoś jednego określonego, rzeczywistego świata, zadajemy natomiast pytania, na które odpowiedź można znaleźć w dużej ilości podobnych światów. W ten sposób przypadek został uznany nie tylko za matematyczne narzędzie fizyki, lecz za istotny element konstrukcji, na której się ta dyscyplina opiera.

To uznanie elementu niecałkowitego determinizmu, niemal elementu irracjonalności w świecie, w jakimś sensie przypomina przyjęcie przez Freuda czynnika irracjonalnego, głęboko tkwiącego w ludzkim postępowaniu i w ludzkich myślach. W obecnym zamęcie politycznym i intelektualnym panuje naturalna skłonność do uważania Gibbsa, Freuda i zwolenników nowoczesnej teorii prawdopodobieństwa za przedstawicieli tego samego kierunku. […]

James C. Scott

James C. Scott (1936–2024) był wybitnym amerykańskim politologiem i antropologiem, profesorem Uniwersytetu Yale. Był jednym z najczęściej czytanych i najbardziej wpływowych myślicieli społecznych swojego pokolenia.

Jego prace koncentrowały się na władzy państwowej, opresji oraz formach oporu ze strony ludzi z nizin społecznych (zwłaszcza społeczeństw agrarnych i chłopskich). Był założycielem Programu Studiów Agrarnych (Program in AgrarianStudies) w Yale.

Najważniejsze Idee i Książki

Scott jest znany z krytycznej analizy interwencji państwowych i wielkich schematów planistycznych.

1. Widzenie jak Państwo (SeeingLike a State, 1998)

To jego najbardziej wpływowa książka, która stała się klasykiem w naukach społecznych.

- Główna teza: Państwa dążą do uproszczenia (uczynienia czytelnym – ang. legibility) złożonej rzeczywistości społecznej i naturalnej (np. poprzez standardowe nazwiska, jednolite miary, katastry).

- Problem: To uproszczenie (tzw. wysoki modernizm) jest niezbędne do sprawowania kontroli (podatki, pobór do wojska, zarządzanie), ale jednocześnie eliminuje lokalną, praktyczną wiedzę (metis), co prowadzi do katastrofalnych, wielkoskalowych porażek w projektach socjalnych i urbanistycznych tak jak kolektywizacja w ZSRR czy nieudane projekty miast.

2. BrońSłabych (Weapons of the Weak, 1985)

- Książka ta stworzyła podwaliny pod tzw. studia oporu (resistancestudies).

- Scott analizował codzienne formy oporu chłopskiego w Malezji, pokazując, że grupy poddane dominacji rzadko organizują spektakularne rewolucje. Zamiast tego angażują się w ciche, „pozakulisowe” akty sabotażu, opóźnienia, udawanej ignorancji i plotek. To jest ich „broń słabych”.

3. Sztuka niebycia rządzonym (The Art of Not Being Governed, 2009)

- W tej pracy Scott badał społeczności w górskich rejonach Azji Południowo-Wschodniej (obszar zwany Zomia), które celowo utrzymywały struktury społeczne i praktyki rolnicze (np. mobilność, brak pisma), aby uniknąć włączenia do państwa i jego opodatkowania oraz kontroli.

Scott jest często postrzegany jako myśliciel bliski anarchizmowi i krytyce technokratycznego zarządzania, co sprawia, że jego prace są popularne zarówno wśród naukowców, jak i aktywistów.

Na koniec powtórzmy główną tezę opisaną w artykule Baruna Mitry:

Dążenie państwa do widzenia wszystkiego i pełnej kontroli społeczeństwa zamienia liczby w narzędzia dominacji, chroniąc władzę przed odpowiedzialnością i jednocześnie pociągając obywateli do coraz ściślejszego rozliczania.